Der AI Act ist der erste Rechtsrahmen der EU für Künstliche Intelligenz und soll nach Ansicht der Europäischen Kommission Europa in die Lage versetzen, weltweit eine führende Rolle bei der Festlegung von globalen Standards zu spielen. Er ist Teil eines umfassenden Pakets politischer Maßnahmen zur Unterstützung und Entwicklung vertrauenswürdiger KI, zu dem auch das KI-Innovationspaket und der koordinierte KI-Plan sowie die AI Liability Directive gehören, die Vorschriften zu außervertraglichen Haftungsfragen iZm KI-Systemen regeln soll. Des Weiteren ist auch eine Überarbeitung der sektoralen Sicherheitsvorschriften (zB Produktsicherheit) geplant.

Der AI Act ist sehr umfangreich, er enthält 180 Erwägungsgründe, 113 Artikel und 13 Anhänge. Er fordert, dass KI-Anwendungen nicht nur effizient, sondern auch sicher, transparent, ethisch korrekt und grundrechtskonform gestaltet sein müssen.

Art. 3 Z 1 definiert ein KI-System wie folgt:

ein maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können;“

Die Nichtbeachtung der Bestimmungen des AI Act ist mit hohen Bußgeldern verbunden und zwar:

- bis zu 35 Mio. EUR bzw. 7 % des weltweiten Jahresumsatzes (abhängig davon, welcher Wert höher ist) bei Missachtung der in Art. 5 genannten KI-Praktiken in Bezug auf verbotene KI-Systeme oder die Nichteinhaltung der Anforderungen an Daten.

- bis zu 15 Mio. EUR bzw. 3 % des weltweiten Jahresumsatzes (abhängig davon, welcher Wert höher ist) bei Verstößen gegen geltende Bestimmungen für Anbieter (Art. 16), Bevollmächtigte (Art. 22) sowie Einführer (Art. 23), Händler (Art. 24), Betreiber (Art. 26), notifizierte Stellen (Art. 31, 33 Abs. 1, 3 und 4, Art. 34), Transparenzpflichten für Anbieter und Nutzer (Art. 50).

- Bis zu 7,5 Mio. EUR bzw. 1 % des weltweiten Jahresumsatzes (abhängig davon, welcher Wert höher ist) bei Falschaussagen bzw. unvollständigen oder irreführenden Informationen an notifizierte Stellen oder zuständige Behörden.

Im Falle von KMUs gilt aber der jeweils niedrigere Betrag.

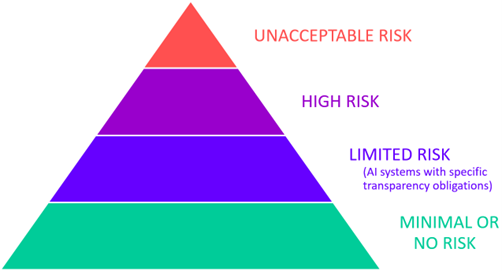

Kern des AI Act ist ein risikobasierter Ansatz, wobei das Risikopotential anhand der nachstehenden vier Risikofelder qualifiziert wird:

Quelle: Europäische Kommission

- Inakzeptables Risiko: Betrifft KI-Systeme, die eine eindeutige Bedrohung für die Sicherheit, die Lebensgrundlage und die Menschenrechte darstellen. Darunter fallen zB KI-Systeme wie Social Scoring, die Menschen sozial bewerten und Systeme zur biometrischen Klassifizierung in Bezug auf die in den Art. 9 und 10 DSGVO als besonders schützenswert angeführten Daten (Art. 5).

- Hohes Risiko: Diese Gruppe stellt den bedeutendsten Anwendungsbereich des AI Act dar und ist aufgrund ihrer Risikoneigung besonders stark reglementiert. Sie behandelt den Einsatz von KI-Systemen in sensiblen Lebensbereichen. In diese Gruppe fallen KI-Systeme in kritischen Infrastrukturen (Verkehr, Wasser, Gas-, Wärme- und Stromversorgung), im Bildungs- und Berufswesen (zB Bewerberauswahl), Strafverfolgung, private und öffentliche Dienstleister (zB Bonitätsprüfung) uä (Art. 6 bis 49, Anhang III).

- Begrenztes Risiko: Umfasst KI-Systeme, von denen nur ein begrenztes Risiko ausgeht wie zB Chatbots. Für diese Gruppe gelten spezifische Transparenzpflichten (Art. 50, Anhang XII).

- Minimales Risiko: Der AI Act erlaubt die freie Nutzung von KI-Systemen mit minimalem Risiko. Diese Gruppe enthält die überwiegende Mehrheit der derzeit in der EU eingesetzten KI-Systeme wie zB Spamfilter oder KI-fähige Videospiele.

In der politischen Diskussion war insb. die Einbeziehung von „General Purpose AI Models“ (GPAI) besonders umstritten. Als „KI-Systeme mit allgemeinem Verwendungszweck“ bezeichnet man KI, die allgemeine Funktionen wie Bild- und Spracherkennung, Videogenerierung, Mustererkennung, Beantwortung von Fragen sowie Übersetzungen usw. ausführt. Darunter fallen Large Language Models (LLM) und andere generative AI-Tools wie ChatGPT, Google Gemini, Bing AI ua. Entsprechend der im AI Act festgelegten Logik werden diese GPAI-Modelle in die dritte Risikostufe eingeordnet. Dabei werden zwei Gruppen unterschieden, und zwar GPAI „mit allgemeinem Verwendungszweck“ und GPAI „mit allgemeinem Verwendungszweck mit systemischem Risiko“. Diese Differenzierung bezieht sich nicht auf die Anwendung selbst, sondern auf die Rechenleistung und Reichweite des zugrundeliegenden Basismodells. Die Rechenleistung wird in Gleitkommaoperationen pro Sekunde (Floating Point Operations Per Second, FLOP) gemessen. Art. 51 Abs. 2 legt den Schwellenwert für GPAI mit allgemeinem Verwendungszweck mit systemischem Risiko mit 1025 FLOP fest.

Der AI Act sieht eine Verwaltungsstruktur mit mehreren zentralen Regulierungsbehörden vor, die jeweils unterschiedliche Aufgaben in Bezug auf die Umsetzung und Durchsetzung des AI Act wahrnehmen sollen. Im Einzelnen sind dies:

Auf EU-Ebene:

- Einrichtung eines Büros für Künstliche Intelligenz, das die Umsetzung und Durchsetzung des AI Act gewährleisten soll (Art. 64). Es wurde bereits am 24. Jänner 2024 gegründet.

- Des Weiteren wird ein „Europäisches Gremium für Künstliche Intelligenz“ eingerichtet, das sowohl die Kommission wie auch die Mitgliedstaaten unterstützen soll, um eine einheitliche und wirksame Anwendung des AI Act zu erleichtern (Art. 65).

- Ein Beratungsforum aus unabhängigen Experten soll den Ausschuss und die Kommission beraten (Art. 67).

- Schlussendlich soll ein wissenschaftliches Gremium unabhängiger Sachverständiger eingerichtet werden, das die Durchsetzungstätigkeiten im Rahmen des AI Act unterstützen soll (Art. 68).

Auf nationaler Ebene:

- Jeder MS muss mindestens eine notifizierende Behörde einrichten, die insb. KMU einschließlich Start-up-Unternehmen bei der Durchführung des AI Act zur Seite stehen und die ordnungsgemäße und rechtzeitige Durchführung von Konformitätsbewertungen sicherstellen soll (Art. 70). Vorerst wurde mit Beschluss des Nationalrates vom 21. Jänner 2024 eine KI-Servicestelle in der Rundfunk und Telekom Regulierungs-GmbH (RTR) eingerichtet, die in einem weiteren Ausbauschritt in eine KI-Behörde übergeht.

- Jeder MS muss darüber hinaus auch mindestens eine Marktüberwachungsbehörde einrichten, die zur Durchführung externer Konformitätsbewertungen berechtigt ist (Art. 70).

Vom AI Act sind unterschiedliche Akteure betroffen (Art. 2):

- Anbieter

- Betreiber

- Einführer und Händler

- Produkthersteller

- Bevollmächtigte von Anbietern

- betroffene Personen

Der Sitz in einem Drittstaat entbindet Anbieter, Betreiber und Bevollmächtigte nicht von den im AI Act normierten Pflichten, wenn das KI-System für die EU bestimmt ist oder das vom KI-System hervorgebrachte Ergebnis in der EU verwendet wird.